9 febbraio 2020, Cade Metz e Adam Satariano per il New York Times.

Le autorità giudiziarie utilizzano un software per determinare le condanne e la libertà vigilata.

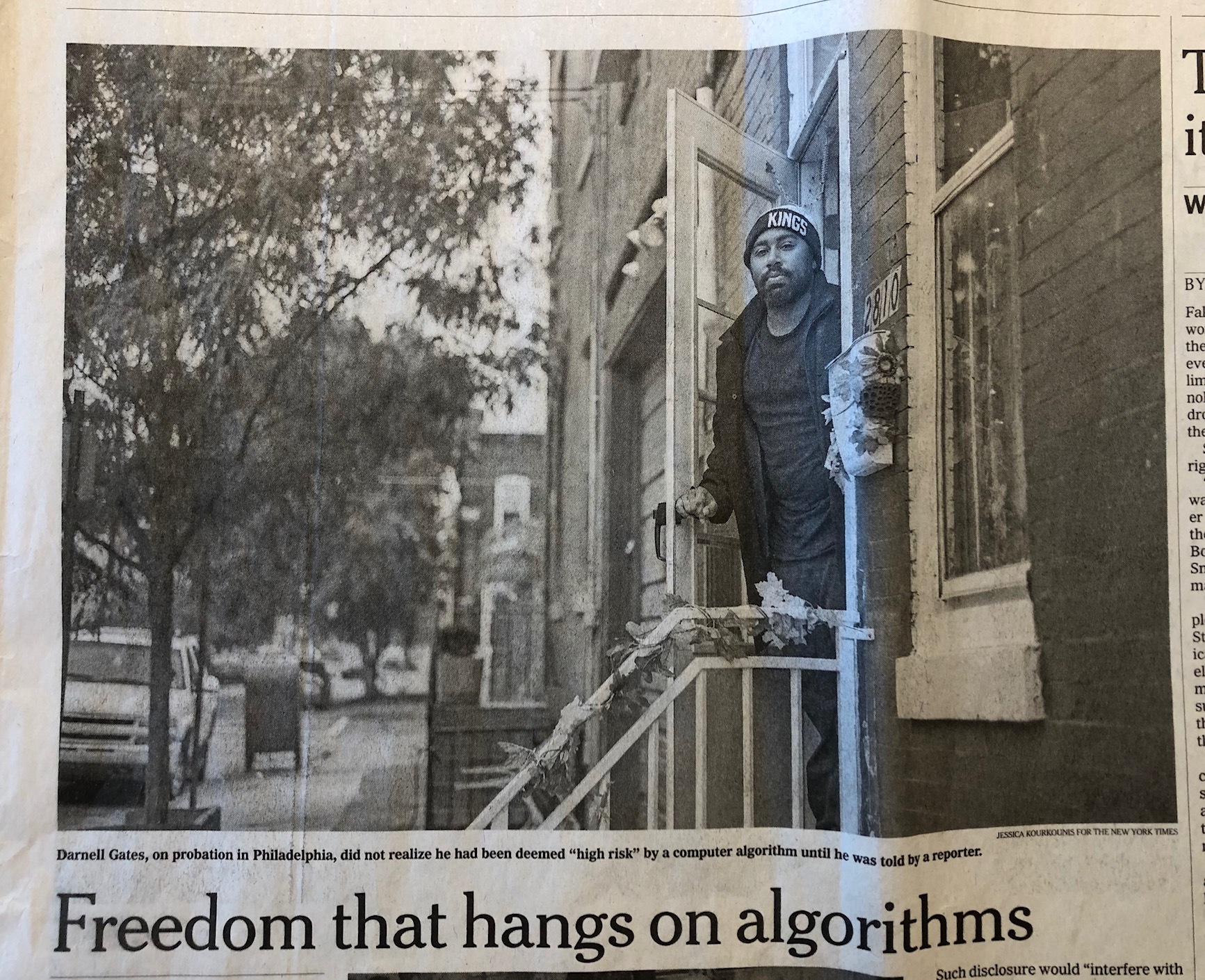

Darnell Gates era seduto ad un lungo tavolo in un ufficio nel centro di Filadelfia, indossava una maglietta nera con scritto “California” in lettere gialle brillanti. Non ci era mai stato, ma sperava di andarci per visitare la famiglia dopo aver terminato la sua libertà vigilata.

Dopo aver scontato una pena per essere andato a sbattere contro una casa nel 2013 e dopo aver minacciato violentemente la sua compagna, Gates esce dal carcere nel 2018 ma, essendo considerato un soggetto ad alto rischio, gli è stato imposto di recarsi presso un ufficio giudiziario una volta alla settimana.

Per Gates le visite sono la “coda” e il “guinzaglio”. Alla fine, il guinzaglio si è allungato a ogni due settimane e poi una volta al mese, senza che Gates fosse a conoscenza del motivo. Si lamentava perché le conversazioni con il personale giudiziario responsabile della libertà vigilata erano fredde e impersonali. Raramente dedicavano il tempo necessario per comprendere la sua riabilitazione.

Gates era all’oscuro del fatto che un algoritmo lo avesse etichettato alto rischio, fino a quando non gli è stato detto durante un’intervista al New York Times. “Che vuol dire?” chiede Gates, 30 anni. “Mi sta dicendo che ho a che fare con tutto questo a causa di un computer?”

L’algoritmo, creato a Philadelphia da un professore dell’Università della Pennsylvania, da almeno cinque anni contribuisce a dettare i termini della libertà vigilata. Quell’algoritmo è uno dei tanti che decidono la vita delle persone negli Stati Uniti e in Europa. Le autorità locali utilizzano i cosiddetti algoritmi predittivi per organizzare le pattuglie di polizia, le pene detentive e i termini della libertà vigilata. Nei Paesi Bassi, esiste un algoritmo che segnala i rischi di frode nel campo del welfare. In una città britannica, un altro valuta quali sono gli adolescenti con più probabilità di diventare criminali.

Secondo Electronic Privacy Information Center – un’organizzazione no profit che si occupa di diritti digitali – quasi ogni Stato dell’America fa uso di questo tipo di algoritmo. Algorithm Watch, un’organizzazione di sorveglianza con sede a Berlino, ha identificato programmi simili in almeno 16 Paesi europei. Nonostante l’uso dell’intelligenza artificiale nel settore della giustizia si stia diffondendo in altri Stati e altri governi, gli organi di controllo delle Nazioni Unite, gli avvocati per i diritti civili, i sindacati e attivisti locali stanno resistendo.

C’è rabbia per la crescente dipendenza da sistemi automatizzati che stanno rimuovendo gli umani e la trasparenza dal processo. Spesso non è chiaro come tali sistemi arrivino a decidere. Il genere è un fattore di cui tener conto? E l’età? E il codice postale? È difficile da dire, dal momento che esistono poche regole che richiedono ai produttori di algoritmi di rivelare le loro formule. Inoltre, come riportato da ProPublica, si teme che le persone che creano gli algoritmi possano avere pregiudizi contro determinate razze, classi sociali e luoghi geografici e che questi possano essere inclusi nel sistema.

A San Jose, in California, viene utilizzato un algoritmo nelle le udienze preliminari; durante questa fase, un’organizzazione, chiamata Silicon Valley DeBug, intervista la famiglia dell’imputato raccogliendo informazioni personali che verranno poi condivise con i difensori per tentare di controbilanciare gli algoritmi.

Due organizzazioni locali, Media Mobilizing Project di Filadelfia e MediaJustice di Oakland in California, hanno recentemente compilato un database nazionale di algoritmi di previsione. Inoltre, Community Justice Exchange, un’organizzazione nazionale che supporta queste organizzazioni, ha iniziato a diffondere una guida di 50 pagine su come affrontare l’uso degli algoritmi.

Gli algoritmi dovrebbero ridurre il carico di lavoro per le agenzie a corto di personale, ridurre i costi governativi e, idealmente, rimuovere i pregiudizi umani. I contrari dicono che i governi non hanno mostrato grande interesse nel cercare di capire cosa significhi rimuovere gli esseri umani dal processo decisionale. Secondo un recente Rapporto delle Nazioni Unite i governi rischiano di “incamminarsi a passo di zombie verso un distopico welfare digitale”.

L’anno scorso, lo Stato dell’Idaho ha approvato una legge che stabilisce che i metodi e i dati utilizzati negli algoritmi per le cauzioni devono essere disponibili al pubblico in modo che sia possibile capire come funzionano. Nei Paesi Bassi, la scorsa settimana, un tribunale distrettuale ha deciso che il software previsto per la frode sociale ha violato il diritto europeo in materia di diritti umani; è una delle prime sentenze contro l’uso da parte del governo di algoritmi predittivi.

“Dov’è la mia interazione umana?” chiedeva Gates, seduto accanto al suo avvocato nella sala riunioni dell’ufficio del difensore pubblico di Filadelfia. “Come si fa a vincere contro un computer che è costruito per fermarti? Come si fa a fermare qualcosa che predetermina il tuo destino?”

Uno sguardo alla frode contro il welfare

L’anno scorso a Rotterdam, nei Paesi Bassi, in due quartieri prevalentemente a basso reddito e ad alta presenza di immigrati, si vociferava che il governo della città avesse iniziato a utilizzare un algoritmo sperimentale per prendere chi commette una frode fiscale o una truffa al sistema di welfare. Mohamed Saidi lo ha appreso da un messaggio WhatsApp, pensando che fosse uno scherzo inizialmente. Mohamed Bouchkhachakhe ne ha sentito parlare la prima volta da sua madre, che lo aveva saputo da un amico. Driss Tabghi ha sentito qualcosa da un sindacalista del posto.

La voce si è rivelata vera alla fine. Il programma olandese, System Risk Indication, analizza i dati provenienti da diverse autorità governative per segnalare chi eventualmente potrebbe richiedere il sussidio di disoccupazione quando in realtà lavorano, oppure il sussidio per l’alloggio per vivere da soli mentre in realtà vivono con altre persone.

Il Ministero degli Affari sociali e dell’occupazione ha detto che i dati potrebbero includere il reddito, il debito, l’istruzione, la proprietà, l’affitto, la proprietà dell’auto, l’indirizzo di casa e le prestazioni sociali ricevute per i bambini, l’alloggio e l’assistenza sanitaria.

L’algoritmo produce i cosiddetti “risk reports” (rapporti sui rischi) su individui che dovrebbero essere interrogati dagli investigatori. A Rotterdam dove il sistema è stato utilizzato recentemente, sono stati prodotti 1.263 dossier su individui provenienti da due quartieri diversi. “Mi hanno inserito in un sistema di cui non sapevo nemmeno l’esistenza”, dice Bouchkhachakhe, impiegato in un’azienda di logistica.

Il programma è avvolto nella segretezza. Perfino chi finisce nella lista non ne è informato. Non viene detto loro né come l’algoritmo decide, né come si può presentare appello. Nel 2019, un’audizione del Consiglio Comunale con il Ministero degli affari sociali si è bruscamente interrotta quando i membri del governo della città si sono rifiutati di firmare un accordo di riservatezza prima di aver ricevuto un briefing su come funzionasse il sistema. Tale divulgazione “interferirebbe con la capacità di investigare efficacemente”, ha detto un portavoce del ministero in risposta alle domande.

Nel rapporto pubblicato a ottobre, il Relatore Speciale dell’ONU sulla povertà estrema e i diritti umani ha criticato il sistema olandese per aver creato uno “un welfare state digitale” che affida alle macchine le decisioni cruciali sulla vita delle persone. “Interi quartieri sono considerati sospetti e sono soggetti ad un controllo speciale, che è l’equivalente digitale di ispettori antifrode che bussano ad ogni porta in una certa area”, si legge nel rapporto. “Non esiste un controllo di questo tipo su che vive in zone più abbienti.”

Giovani sotto osservazione

Nelle aree colpite da anni dai tagli di bilancio, gli algoritmi rappresentano un modo per contribuire a supplire alla riduzione dei servizi sociali. La tecnologia, dicono i funzionari, aiuta a fare di più con meno risorse e ad identificare le persone che possono sfuggire.

Una volta alla settimana a Bristol, in Inghilterra, un team si riunisce per esaminare i risultati di un algoritmo creato per identificare i giovani più a rischio e rivedere il numero di casi. In genere alla riunione in cui viene passata in rassegna la lista dei nomi partecipano membri della polizia, dei servizi per l’infanzia e il membro del team che ha progettato il software.

Con i casi di violenza giovanile e criminalità in aumento, e con la chiusura di molti programmi e centri per giovani, il governo locale è ricorso al software per identificare i ragazzi più bisognosi. Gli addetti ai lavori affermano che il sistema funziona se la tecnologia e l’intervento umano vengono combinati.

L’anno scorso, a Bristol, è stato introdotto un programma che calcola il rischio basandosi su dati estratti dai rapporti della polizia, dai sussidi sociali e da altre fonti. Il sistema opera grazie ai dati sulla criminalità, sull’abitazione e su qualsiasi altro legame noto con altri individui con un alto coefficiente di rischio, e anche se i genitori del giovane sono coinvolti in un incidente domestico. Le scuole forniscono il dato sulle presenze.

“È possibile ottenere un quadro abbastanza completo”, dice Tom Fowler, 29 anni, autore del sistema di punteggio giovanile per l’amministrazione di Bristol, che si è mostrata disponibile a discutere il programma con la popolazione, pubblicando alcune informazioni online e tenendo eventi nella comunità. I detrattori, tuttavia, dicono che non è ancora del tutto trasparente.

I giovani e le loro famiglie non sanno se sono nella lista, né è stato comunicato loro un modo per contestare l’eventuale inserimento. Charlene Richardson e Desmond Brown, due impiegati comunali, sono i responsabili per gli interventi e gli aiuti a favore dei giovani che sono stati segnalati dal software. “Abbiamo messo insieme tutti i pezzi” dice Richardson, che prima di esser assunta ha diretto per venti anni i centri giovanili della zona. “Sappiamo che il computer a volte sbaglia.”

Inizialmente entrambi erano preoccupati che il sistema venisse ingiustamente applicato soprattutto ai ragazzi di colore. Adesso sono però sicuri che la macchina aiuta a identificare i bambini che hanno bisogno di aiuto. “Non è ‘Minority Report'”, dice Brown, riferendosi al film di Steven Spielberg del 2002. “Non ci affidiamo solo al computer”. I due affermano di concentrarsi soprattutto su bambini con un alto punteggio di rischio, e perciò effettuano visite a domicilio, parlano con i professori e trovano mentori nella comunità. “Devono essere visti come vittime”, dice lei.

Traduzione: Federica Donati